Przewodniki dotyczące poszczególnych platform

Android (Kotlin/Java)

Android NDK (C)

Unity (AR Foundation)

iOS

Unreal Engine

Interfejs Augmented Faces API umożliwia renderowanie zasobów na twarzach ludzi bez użycia specjalistycznego sprzętu. Udostępnia on punkty charakterystyczne, które umożliwiają aplikacji automatyczne rozpoznawanie różnych obszarów wykrytej twarzy. Aplikacja może następnie używać tych regionów do nakładania zasobów w sposób, który odpowiednio dopasowuje kontury twarzy.

Przypadki użycia

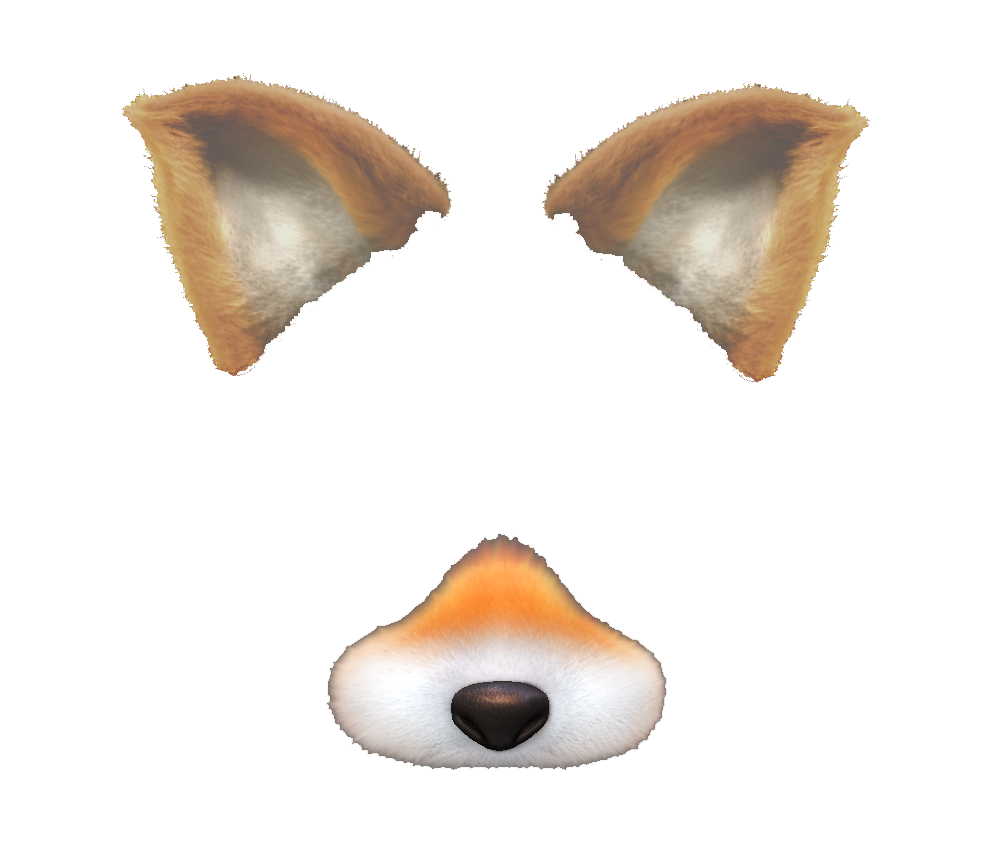

AR na podstawie twarzy umożliwia wiele zastosowań, od testowania kosmetyków i akcesoriów po filtry i efekty do twarzy, z których użytkownicy mogą korzystać wspólnie ze znajomymi. Możesz na przykład użyć modeli 3D i tekstury, aby nałożyć cechy lisa na twarz użytkownika.

Model składa się z 2 lisich uszu i lisiego nosa. Każdy z nich to osobny element, który można przesuwać pojedynczo, aby podążał za obszarem twarzy, do którego jest przymocowany.

Tekstura zawiera cień do powiek, piegi i inne kolory.

Podczas działania interfejs Augmented Faces API wykrywa twarz użytkownika i nakłada na nią teksturę oraz modele.

Elementy rozszerzonej twarzy

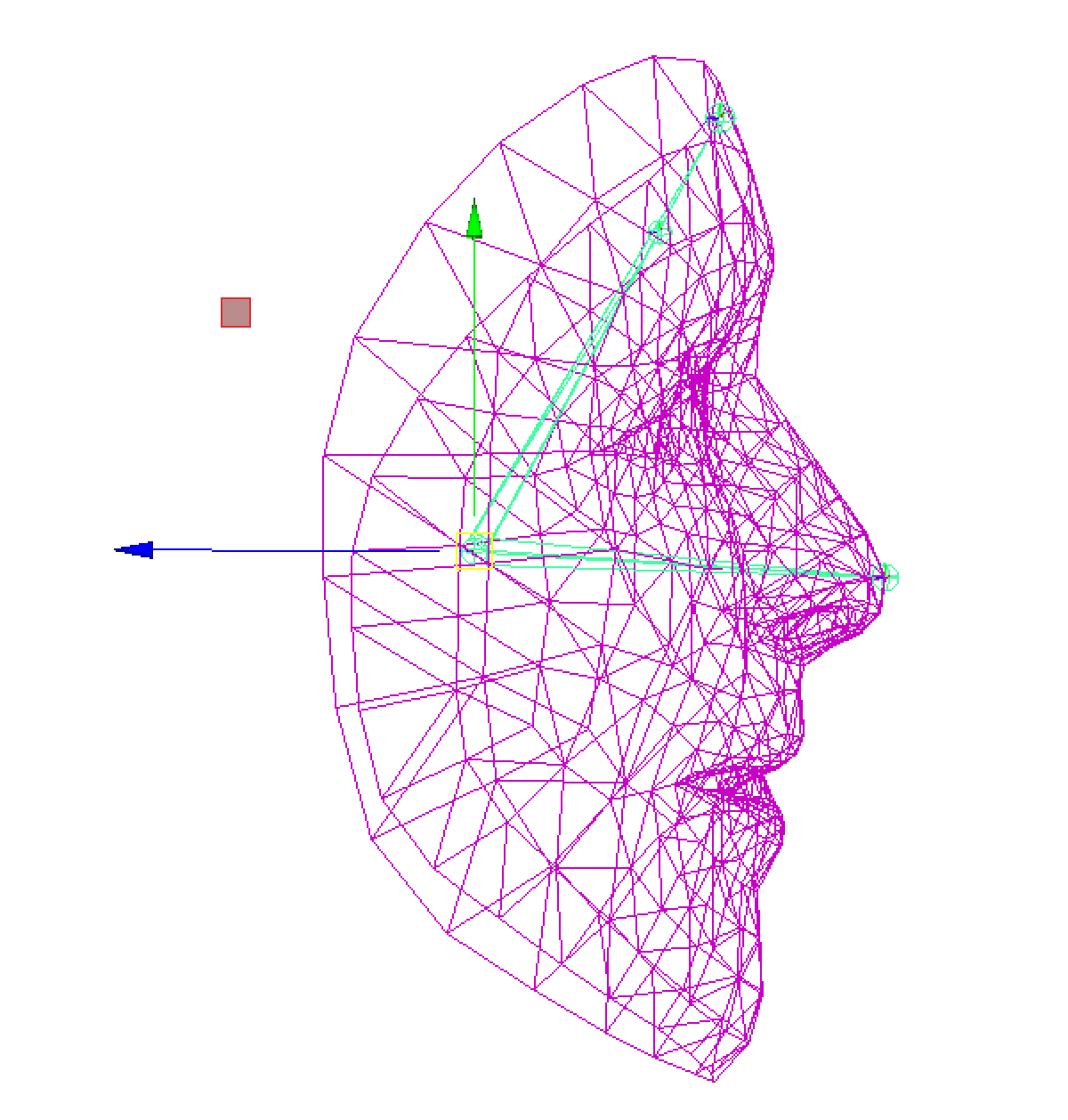

Interfejs Augmented Faces API udostępnia pozę środkową, 3 pozy regionu i siatkę 3D twarzy.

Pozycja środkowa

Znajduje się ona za nosem i oznacza środek głowy użytkownika. Używaj go do renderowania zasobów, takich jak kapelusz na głowie.

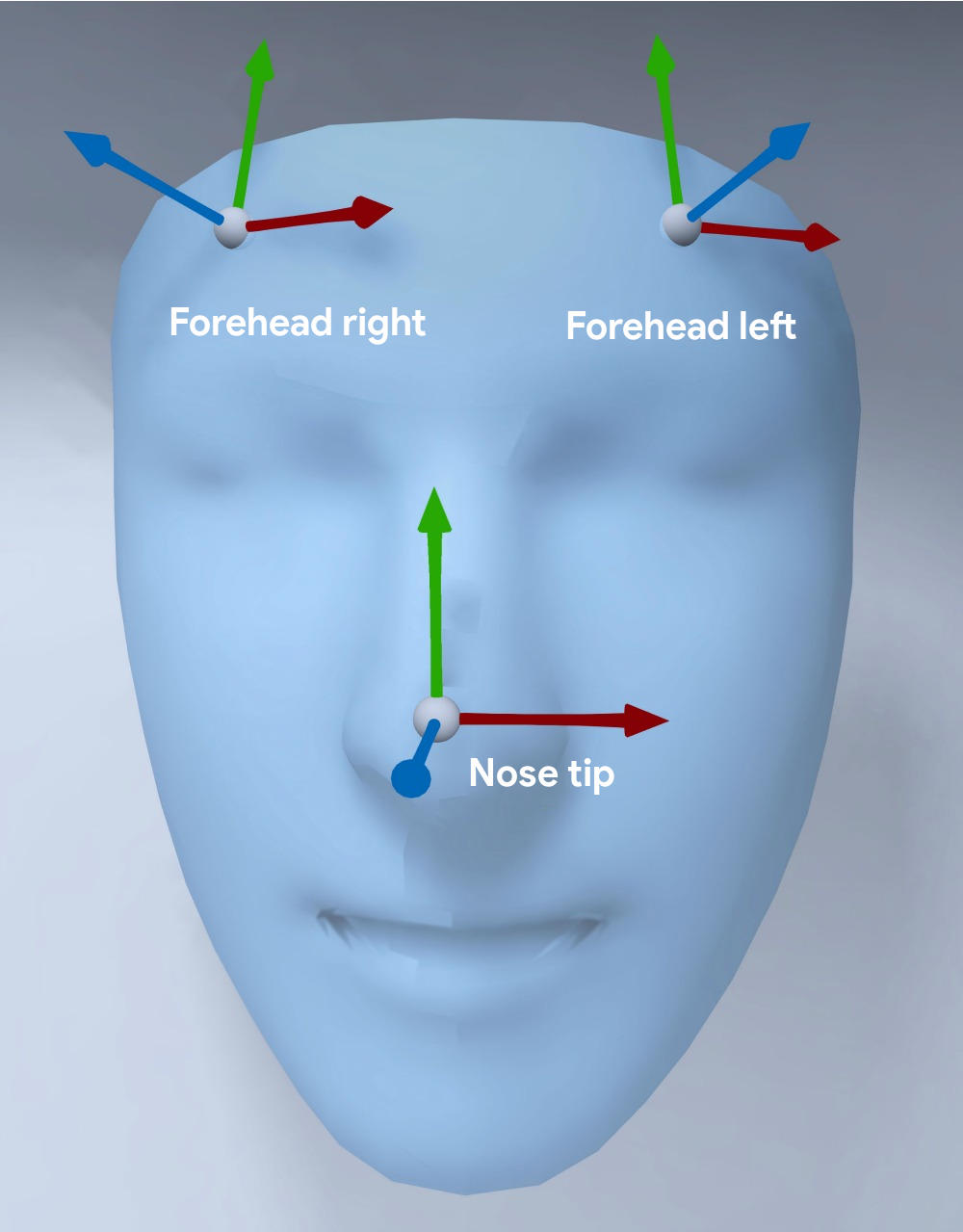

Pozy regionalne

Znajdują się one na lewym i prawym czole oraz na czubku nosa. Oznaczają one ważne części twarzy użytkownika. Użyj ich do renderowania zasobów na nosie lub wokół uszu.

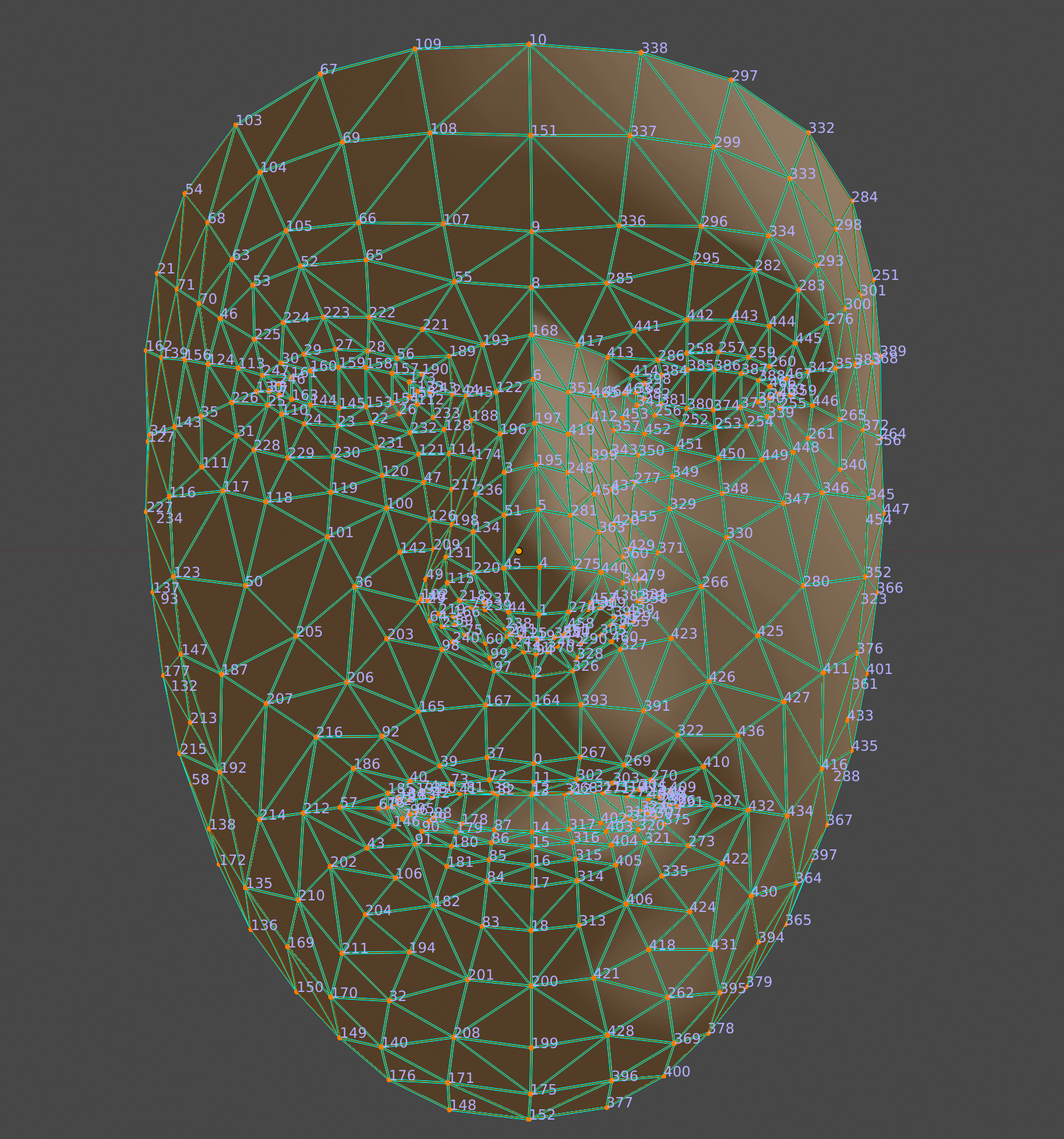

Siatka na twarz

Gęsta siatka 3D o rozdzielczości 468 punktów pozwala na malowanie dostosowanych, szczegółowych tekstur, które dokładnie odwzorowują twarz – na przykład w przypadku nakładania wirtualnych okularów na określony obszar nosa. Siatka zbiera wystarczająco szczegółowe informacje 3D, aby można było łatwo wyrenderować ten obraz wirtualny.