هدف

آموزش اعتبارسنجی آدرس با حجم بالا شما را در سناریوهای مختلفی که میتوان از اعتبارسنجی آدرس با حجم بالا استفاده کرد، راهنمایی کرد. در این آموزش، شما را با الگوهای طراحی مختلف در پلتفرم ابری گوگل برای اجرای اعتبارسنجی آدرس با حجم بالا آشنا خواهیم کرد.

ما با مروری بر اجرای اعتبارسنجی آدرس با حجم بالا در پلتفرم ابری گوگل با Cloud Run، Compute Engine یا Google Kubernetes Engine برای اجراهای یکباره شروع خواهیم کرد. سپس خواهیم دید که چگونه میتوان این قابلیت را به عنوان بخشی از یک خط لوله داده گنجاند.

در پایان این مقاله، شما باید درک خوبی از گزینههای مختلف برای اجرای اعتبارسنجی آدرس در حجم بالا در محیط Google Cloud خود داشته باشید.

معماری مرجع در پلتفرم ابری گوگل

این بخش به بررسی عمیقتر الگوهای طراحی مختلف برای اعتبارسنجی آدرس با حجم بالا با استفاده از پلتفرم ابری گوگل میپردازد. با اجرا بر روی پلتفرم ابری گوگل، میتوانید آن را با فرآیندها و خطوط لوله داده موجود خود ادغام کنید.

اجرای اعتبارسنجی آدرس با حجم بالا یک بار در پلتفرم ابری گوگل

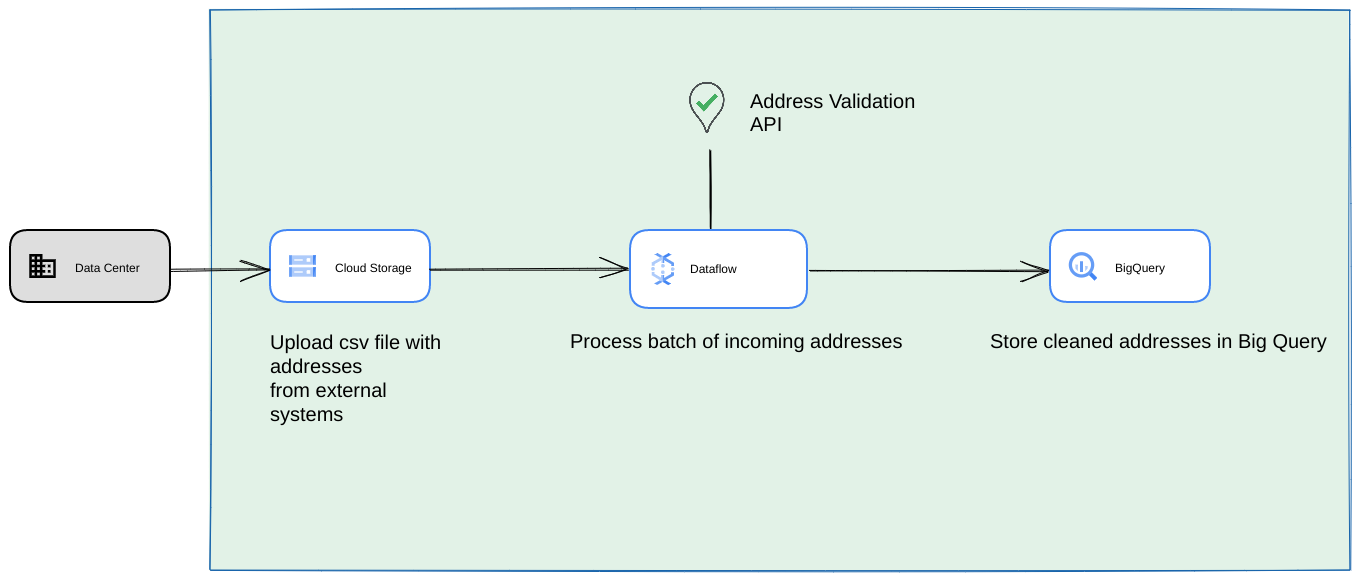

در زیر یک معماری مرجع از نحوه ایجاد یکپارچهسازی در پلتفرم ابری گوگل نشان داده شده است که برای عملیات یا آزمایشهای یکباره مناسبتر است.

در این حالت، توصیه میکنیم فایل CSV را در یک فضای ذخیرهسازی ابری (Cloud Storage Bucket) آپلود کنید. اسکریپت اعتبارسنجی آدرس با حجم بالا (High Volume Address Validation) سپس میتواند از یک محیط Cloud Run اجرا شود. با این حال، میتوانید آن را در هر محیط زمان اجرای دیگری مانند Compute Engine یا Google Kubernetes Engine اجرا کنید. CSV خروجی را نیز میتوان در فضای ذخیرهسازی ابری آپلود کرد.

اجرا به عنوان یک خط لوله داده Google Cloud Platform

الگوی استقرار نشان داده شده در بخش قبلی برای آزمایش سریع اعتبارسنجی آدرس با حجم بالا برای استفاده یکباره عالی است. با این حال، اگر نیاز دارید که به طور منظم از آن به عنوان بخشی از یک خط لوله داده استفاده کنید، میتوانید از قابلیتهای بومی پلتفرم ابری گوگل برای تقویت آن بهتر استفاده کنید. برخی از تغییراتی که میتوانید ایجاد کنید عبارتند از:

- در این حالت، میتوانید فایلهای CSV را در سطلهای ذخیرهسازی ابری ذخیره کنید.

- یک کار Dataflow میتواند آدرسهایی را که باید پردازش شوند، دریافت کرده و سپس در BigQuery ذخیره کند.

- کتابخانه پایتون Dataflow را میتوان طوری توسعه داد که منطقی برای اعتبارسنجی آدرسهای با حجم بالا داشته باشد تا آدرسهای حاصل از کار Dataflow را اعتبارسنجی کند.

اجرای اسکریپت از یک خط لوله داده به عنوان یک فرآیند تکرارشونده طولانی مدت

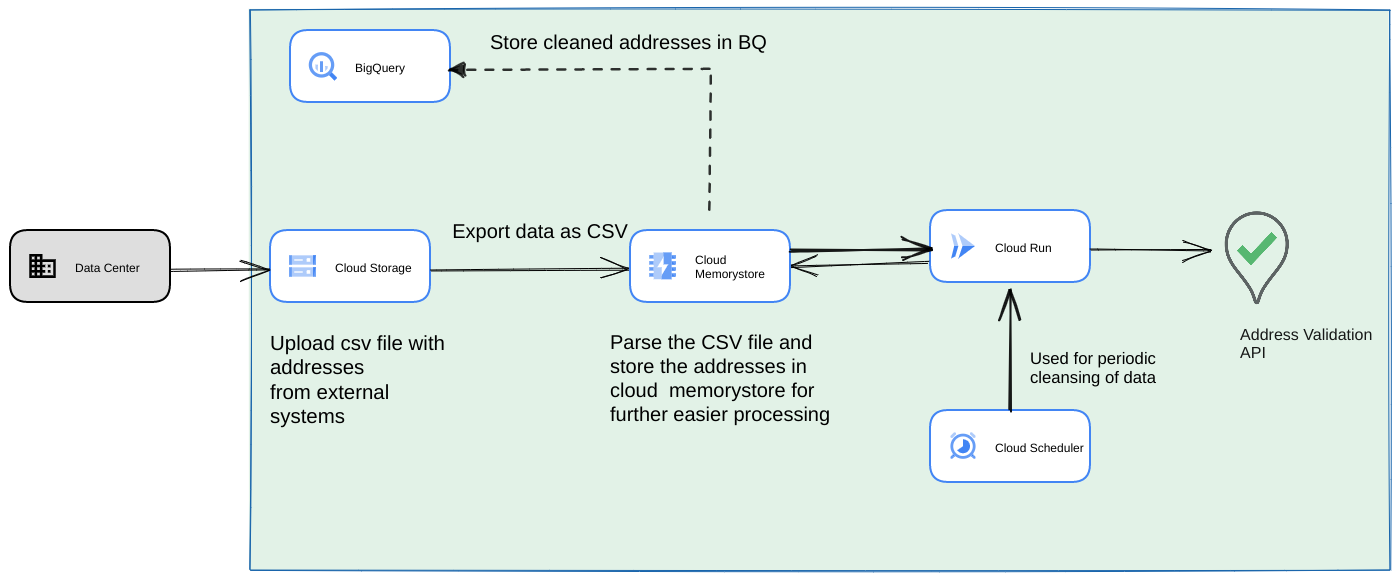

رویکرد رایج دیگر، اعتبارسنجی دستهای از آدرسها به عنوان بخشی از یک خط لوله داده جریانی به عنوان یک فرآیند تکرارشونده است. همچنین ممکن است آدرسها را در یک پایگاه داده bigquery داشته باشید. در این رویکرد، خواهیم دید که چگونه یک خط لوله داده تکرارشونده (که باید روزانه/هفتگی/ماهانه فعال شود) ایجاد کنیم.

- فایل CSV اولیه را در یک فضای ذخیرهسازی ابری آپلود کنید.

- از Memorystore به عنوان یک Datastore پایدار برای حفظ حالت میانی برای فرآیند طولانی مدت استفاده کنید.

- آدرسهای نهایی را در یک پایگاه داده BigQuery ذخیره کنید.

- Cloud Scheduler را طوری تنظیم کنید که اسکریپت را به صورت دورهای اجرا کند.

این معماری مزایای زیر را دارد:

- با استفاده از Cloud Scheduler ، اعتبارسنجی آدرس میتواند به صورت دورهای انجام شود. ممکن است بخواهید آدرسها را به صورت ماهانه مجدداً اعتبارسنجی کنید یا هر آدرس جدید را به صورت ماهانه/سهماهه اعتبارسنجی کنید. این معماری به حل این مشکل کمک میکند.

اگر دادههای مشتری در BigQuery باشد، آدرسهای اعتبارسنجی شده یا پرچمهای اعتبارسنجی میتوانند مستقیماً در آنجا ذخیره شوند. توجه: آنچه که میتواند ذخیره شود و نحوه آن به تفصیل در مقاله اعتبارسنجی آدرس با حجم بالا توضیح داده شده است.

استفاده از Memorystore، انعطافپذیری و توانایی بالاتری را برای پردازش آدرسهای بیشتر فراهم میکند. این مرحله، قابلیت Statefulness را به کل خط پردازش اضافه میکند که برای مدیریت مجموعه دادههای آدرس بسیار بزرگ مورد نیاز است. سایر فناوریهای پایگاه داده مانند cloud SQL [https://cloud.google.com/sql] یا هر نوع پایگاه داده دیگری که Google cloud Platform ارائه میدهد، نیز میتوانند در اینجا مورد استفاده قرار گیرند. با این حال، ما معتقدیم که memorystore perfectless نیازهای مقیاسپذیری و سادگی را متعادل میکند، بنابراین باید اولین انتخاب باشد.

نتیجهگیری

با اعمال الگوهای شرح داده شده در اینجا، میتوانید از API اعتبارسنجی آدرس برای موارد استفاده مختلف و از موارد استفاده مختلف در پلتفرم ابری گوگل استفاده کنید.

ما یک کتابخانه پایتون متنباز نوشتهایم تا به شما در شروع کار با موارد استفادهای که در بالا توضیح داده شد، کمک کند. این کتابخانه را میتوان از طریق خط فرمان روی رایانه خود یا از طریق پلتفرم ابری گوگل یا سایر ارائهدهندگان ابری فراخوانی کرد.

برای آشنایی بیشتر با نحوه استفاده از کتابخانه، به این مقاله مراجعه کنید.

مراحل بعدی

گزارش بهبود پرداخت، تحویل و عملیات با آدرسهای معتبر را دانلود کنید و وبینار بهبود پرداخت، تحویل و عملیات با اعتبارسنجی آدرس را مشاهده کنید.

مطالعه بیشتر پیشنهادی:

- مستندات API اعتبارسنجی آدرس

- اعتبارسنجی آدرس و کدگذاری جغرافیایی

- نسخه آزمایشی اعتبارسنجی آدرس را بررسی کنید

مشارکتکنندگان

گوگل این مقاله را نگهداری میکند. نویسندگان زیر در ابتدا آن را نوشتهاند.

نویسندگان اصلی:

هنریک والو | مهندس راهکارها

توماس انگلارت | مهندس راهکارها

سرتاک گنگولی | مهندس راه حل