Giới thiệu: nguyên nhân và cách giảm thiểu độ trễ DNS

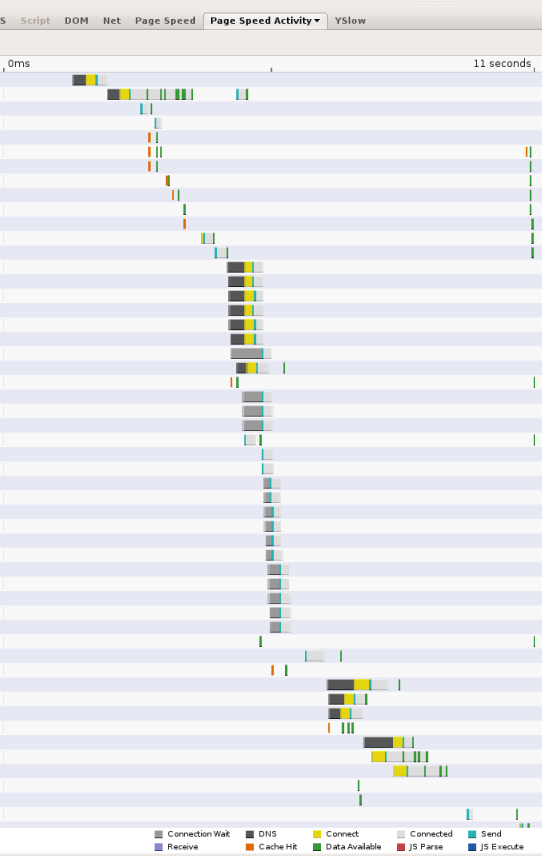

Khi các trang web trở nên phức tạp hơn, việc tham chiếu tài nguyên từ nhiều miền, thì hoạt động tra cứu DNS có thể trở thành điểm tắc nghẽn đáng kể trong trải nghiệm duyệt web. Bất cứ khi nào một ứng dụng cần truy vấn trình phân giải DNS qua mạng, độ trễ tạo ra có thể đáng kể, tuỳ thuộc vào mức độ gần và số máy chủ định danh mà trình phân giải phải truy vấn (hiếm khi có hơn 2 máy chủ). Ví dụ: ảnh chụp màn hình sau đây cho thấy thời gian do công cụ đo lường hiệu suất web Page Speed (Tốc độ trang) báo cáo. Mỗi thanh đại diện cho một tài nguyên được tham chiếu từ trang; các phân đoạn màu đen biểu thị hoạt động tra cứu DNS. Trên trang này, 13 lượt tra cứu được thực hiện trong 11 giây đầu tiên mà trang được tải. Mặc dù một số hoạt động tra cứu được thực hiện song song, ảnh chụp màn hình cho thấy người dùng cần có 5 lần tra cứu nối tiếp, chiếm vài giây trong tổng thời gian tải trang là 11 giây.

Có 2 thành phần đối với độ trễ DNS:

- Độ trễ giữa ứng dụng (người dùng) và máy chủ phân giải DNS. Trong hầu hết các trường hợp, điều này chủ yếu là do các hạn chế về thời gian khứ hồi (RTT) thông thường trong các hệ thống được kết nối mạng: khoảng cách địa lý giữa máy khách và máy chủ; tắc nghẽn mạng; mất gói dữ liệu và độ trễ truyền lại lâu (trung bình một giây); máy chủ quá tải, tấn công từ chối dịch vụ, v.v.

- Độ trễ giữa quá trình phân giải máy chủ và máy chủ định danh khác.

Nguồn gây ra độ trễ này chủ yếu là do các yếu tố sau gây ra:

- Bộ nhớ đệm bị thiếu. Nếu không thể phân phát phản hồi từ bộ nhớ đệm của trình phân giải nhưng yêu cầu truy vấn đệ quy các máy chủ định danh khác, thì độ trễ mạng tăng thêm là đáng kể, đặc biệt nếu các máy chủ đáng tin cậy nằm ở xa về mặt địa lý.

- Chưa cấp phép. Nếu trình phân giải DNS bị quá tải, các trình phân giải này phải xếp hàng các yêu cầu và phản hồi phân giải DNS, đồng thời có thể bắt đầu bỏ và truyền lại các gói.

- Lưu lượng truy cập độc hại. Ngay cả khi dịch vụ DNS được cấp phép quá mức, lưu lượng truy cập DoS vẫn có thể đặt máy chủ quá mức. Tương tự, các cuộc tấn công kiểu Kaminsky có thể liên quan đến trình phân giải tràn ngập với các truy vấn được đảm bảo bỏ qua bộ nhớ đệm và đòi hỏi phải gửi yêu cầu giải quyết đi.

Chúng tôi tin rằng hệ số thiếu bộ nhớ đệm là nguyên nhân chủ yếu gây ra độ trễ của DNS, và chúng tôi sẽ thảo luận thêm về vấn đề này ở bên dưới.

Số lần bỏ lỡ bộ nhớ đệm

Ngay cả khi trình phân giải có nhiều tài nguyên cục bộ, thì cũng khó có thể tránh được các độ trễ cơ bản liên quan đến việc kết nối với máy chủ định danh từ xa. Nói cách khác, giả sử trình phân giải được cung cấp đủ tốt để các lượt truy cập vào bộ nhớ đệm không mất thời gian ở phía máy chủ, thì việc bỏ lỡ bộ nhớ đệm vẫn rất tốn kém về độ trễ. Để xử lý trường hợp bỏ lỡ, trình phân giải phải giao tiếp với ít nhất một, nhưng thường là hai hoặc nhiều máy chủ định danh bên ngoài. Khi vận hành trình thu thập dữ liệu web Googlebot, chúng tôi nhận thấy thời gian phân giải trung bình là 130 mili giây đối với các máy chủ định danh phản hồi. Tuy nhiên, có toàn bộ 4-6% yêu cầu bị hết thời gian chờ do bị mất gói UDP và không thể truy cập vào máy chủ. Nếu chúng tôi tính đến các lỗi như mất gói, máy chủ định danh bị chết, lỗi cấu hình DNS, v.v., thì thời gian phân giải hai đầu trung bình thực tế là 300-400 mili giây. Tuy nhiên, có sự chênh lệch lớn và nhiều thời gian phân giải.

Mặc dù tỷ lệ bỏ lỡ bộ nhớ đệm có thể khác nhau giữa các máy chủ DNS, nhưng cơ bản để tránh bỏ lỡ bộ nhớ đệm là rất khó, vì những lý do sau:

- Kích thước và sự tăng trưởng Internet. Khá đơn giản, khi Internet phát triển, cả thông qua việc có thêm người dùng mới và trang web mới, hầu hết nội dung đều là nội dung ít được quan tâm. Mặc dù một số trang web (và do đó là tên DNS) rất phổ biến, nhưng hầu hết chỉ có một vài người dùng quan tâm và hiếm khi được truy cập; vì vậy, phần lớn yêu cầu đều dẫn đến bỏ lỡ bộ nhớ đệm.

- Giá trị thời gian tồn tại (TTL) thấp. Việc giá trị TTL DNS thấp hơn đồng nghĩa với việc các độ phân giải cần phải được tra cứu thường xuyên hơn.

- Tách biệt bộ nhớ đệm. Máy chủ DNS thường được triển khai phía sau trình cân bằng tải để gán các truy vấn cho các máy khác nhau một cách ngẫu nhiên. Điều này dẫn đến việc mỗi máy chủ riêng lẻ duy trì một bộ nhớ đệm riêng thay vì có thể sử dụng lại độ phân giải đã lưu vào bộ nhớ đệm từ một nhóm dùng chung.

Giải pháp giảm thiểu

Trong Google Public DNS, chúng tôi đã triển khai một số phương pháp để tăng tốc thời gian tra cứu DNS. Một số phương pháp trong số này khá chuẩn mực; một số phương pháp khác chỉ mang tính thử nghiệm:

- Cung cấp đầy đủ cho máy chủ để xử lý tải từ lưu lượng truy cập của máy khách, bao gồm cả lưu lượng truy cập độc hại.

- Ngăn chặn các cuộc tấn công từ chối dịch vụ và tấn công khuếch đại. Mặc dù đây chủ yếu là vấn đề bảo mật và ảnh hưởng đến các trình phân giải đóng ít hơn các trình phân giải mở, nhưng việc ngăn chặn các cuộc tấn công DoS cũng có lợi về hiệu suất bằng cách loại bỏ gánh nặng bổ sung về lưu lượng truy cập đặt lên máy chủ DNS. Để biết thông tin về các phương pháp chúng tôi đang sử dụng để giảm thiểu nguy cơ bị tấn công, hãy xem trang về các lợi ích về bảo mật.

- Cân bằng tải cho việc lưu vào bộ nhớ đệm dùng chung để cải thiện tỷ lệ truy cập vào bộ nhớ đệm tổng hợp trên cụm phân phát.

- Cung cấp phạm vi phủ sóng toàn cầu để mang đến sự gần gũi cho tất cả người dùng.

Cung cấp cụm phân phát đầy đủ

Việc lưu vào bộ nhớ đệm các trình phân giải DNS phải thực hiện nhiều thao tác tốn kém hơn so với máy chủ định danh đáng tin cậy, vì nhiều phản hồi không thể phân phát từ bộ nhớ; thay vào đó, các phản hồi này yêu cầu giao tiếp với các máy chủ định danh khác và do đó đòi hỏi nhiều dữ liệu đầu vào/đầu ra của mạng. Hơn nữa, trình phân giải mở rất dễ bị nhiễm độc bộ nhớ đệm, làm tăng tỷ lệ bỏ lỡ bộ nhớ đệm (các cuộc tấn công như vậy gửi yêu cầu đối với các tên giả mạo không thể phân giải từ bộ nhớ đệm) cũng như các cuộc tấn công DoS làm tăng lưu lượng truy cập. Nếu trình phân giải không được cung cấp đầy đủ và không thể bắt kịp tải, thì điều này có thể gây ảnh hưởng rất tiêu cực đến hiệu suất. Các gói bị bỏ qua và cần được truyền lại, các yêu cầu máy chủ định danh phải được đưa vào hàng đợi, v.v. Tất cả các yếu tố này đều góp phần làm chậm trễ.

Do đó, điều quan trọng là bạn phải cấp phép cho các trình phân giải DNS cho hoạt động đầu vào/đầu ra với khối lượng lớn. Điều này bao gồm việc xử lý các cuộc tấn công DDoS có thể xảy ra, trong đó giải pháp hiệu quả duy nhất là cung cấp quá mức trên nhiều máy. Tuy nhiên, đồng thời, bạn không nên giảm tỷ lệ truy cập vào bộ nhớ đệm khi thêm máy. Điều này đòi hỏi bạn phải triển khai một chính sách cân bằng tải hiệu quả mà chúng tôi thảo luận dưới đây.

Cân bằng tải cho bộ nhớ đệm dùng chung

Việc mở rộng quy mô cơ sở hạ tầng trình phân giải bằng cách thêm máy thực sự có thể phản tác dụng và giảm tỷ lệ truy cập vào bộ nhớ đệm nếu việc cân bằng tải không được thực hiện đúng cách. Trong một quy trình triển khai thông thường, nhiều máy nằm phía sau một trình cân bằng tải giúp phân bổ lưu lượng truy cập đồng đều cho từng máy, bằng một thuật toán đơn giản như vòng tròn. Kết quả là mỗi máy duy trì bộ nhớ đệm độc lập riêng để nội dung đã lưu vào bộ nhớ đệm được tách riêng giữa các máy. Nếu mỗi truy vấn đến được phân phối đến một máy ngẫu nhiên, tuỳ thuộc vào tính chất của lưu lượng truy cập, thì tỷ lệ thiếu bộ nhớ đệm hiệu quả có thể tăng lên theo tỷ lệ. Ví dụ: đối với những tên có TTL dài được truy vấn nhiều lần, tốc độ bỏ lỡ bộ nhớ đệm có thể tăng theo số lượng máy trong cụm. (Đối với những tên có TTL rất ngắn, không được truy vấn thường xuyên hoặc dẫn đến phản hồi không thể lưu vào bộ nhớ đệm (0 TTL và lỗi), thì tỷ lệ bỏ lỡ bộ nhớ đệm không thực sự bị ảnh hưởng khi thêm máy.)

Để tăng tỷ lệ truy cập cho tên có thể lưu vào bộ nhớ đệm, điều quan trọng là bạn phải cân bằng tải máy chủ để bộ nhớ đệm không bị phân mảnh. Trong DNS Google Public, chúng tôi có hai cấp độ lưu vào bộ nhớ đệm. Trong một nhóm máy, rất gần người dùng, một bộ nhớ đệm nhỏ cho mỗi máy chứa những tên phổ biến nhất. Nếu không đáp ứng được một truy vấn từ bộ nhớ đệm này, thì truy vấn đó sẽ được gửi đến một nhóm máy khác có nhiệm vụ phân vùng bộ nhớ đệm theo tên. Đối với bộ nhớ đệm cấp hai này, mọi truy vấn có cùng tên sẽ được gửi đến cùng một máy, trong đó tên sẽ được lưu vào bộ nhớ đệm hoặc không.

Phân phối cụm phân phát cho phạm vi địa lý rộng

Đối với các trình phân giải đã đóng, đây thực sự không phải là vấn đề. Đối với các trình phân giải mở, máy chủ của bạn càng ở gần người dùng thì độ trễ ở phía máy khách càng giảm. Ngoài ra, việc có đủ phạm vi địa lý có thể gián tiếp cải thiện độ trễ hai đầu, vì máy chủ định danh thường trả về kết quả được tối ưu hoá cho vị trí của trình phân giải DNS. Nghĩa là, nếu một nhà cung cấp nội dung lưu trữ các trang web được đồng bộ hoá hai chiều trên khắp thế giới, thì máy chủ định danh của nhà cung cấp đó sẽ trả về địa chỉ IP gần nhất với trình phân giải DNS.

Google Public DNS được lưu trữ tại các trung tâm dữ liệu trên toàn thế giới và sử dụng định tuyến Anycast để đưa người dùng đến trung tâm dữ liệu gần nhất về mặt địa lý.

Ngoài ra, DNS Google Public hỗ trợ mạng con máy khách EDNS (ECS), một tiện ích giao thức DNS dành cho trình phân giải để chuyển tiếp vị trí ứng dụng đến máy chủ định danh. Tiện ích này có thể trả về phản hồi phân giải theo vị trí được tối ưu hoá cho địa chỉ IP máy khách thực tế, thay vì địa chỉ IP của trình phân giải. Vui lòng đọc Câu hỏi thường gặp này để biết chi tiết. Google Public DNS tự động phát hiện máy chủ định danh hỗ trợ mạng con máy khách EDNS.