Montag, 12. August 2019

Meistens funktioniert unsere Suchmaschine einwandfrei. Unsere Teams arbeiten intensiv daran, Probleme schon im Vorfeld zu verhindern, damit die Probleme weder die Nutzer der Suche stören noch die Webmaster beeinträchtigen, deren Websites wir indexieren und ausliefern. Auch bei den zugrunde liegenden Systemen funktioniert in der Regel alles wie vorgesehen. Sollten doch einmal kleine Störungen auftreten, sind diese meistens nur für unsere Teams zu erkennen. Diese sorgen dann dafür, dass sich alle Produkte wieder nutzen lassen. Wie bei allen komplexen Systemen gibt es aber manchmal auch hier größere Ausfälle, die sowohl Nutzer als auch Ersteller von Websites beeinträchtigen können.

In den letzten Monaten kam es bei unseren Indexierungssystemen zu einer solchen Situation, die sich auch auf andere Teile unserer Infrastruktur ausgewirkt hat. Wir haben uns bemüht, das Problem so schnell wie möglich zu lösen, möchten uns an dieser Stelle aber dennoch für die Störung entschuldigen – unser Ziel ist es schließlich, Nutzern und Websiteinhabern zu jeder Zeit hochwertige Produkte und Plattformen zur Verfügung zu stellen.

Inzwischen haben wir uns die Situation genauer angesehen. Dabei haben wir einige Lektionen gelernt, die wir heute mit euch teilen möchten. In diesem Blogpost erläutern wir, was genau passiert ist, erklären, wie wir künftig in solchen Situationen besser kommunizieren werden, und informieren Websiteinhaber, wie sie uns bei Bedarf erreichen können.

Was ist passiert?

Im April hatten wir mit unserem Suchindex verschiedene Probleme. Der Suchindex ist die Datenbank, die die Hunderten von Milliarden Webseiten enthält, die wir gecrawlt haben und von denen wir glauben, dass sie für Suchanfragen nützlich sein könnten. Wenn ein Nutzer eine Suchanfrage in die Google-Suchmaschine eingibt, durchsuchen unsere Ranking-Algorithmen diese Seiten in unserem Suchindex und finden im Bruchteil einer Sekunde die relevantesten und nützlichsten Ergebnisse. Nachfolgend erfahrt ihr mehr darüber, was passiert ist.

1. Das Problem mit der Indexierung

Wir haben vorübergehend einen Teil des Suchindex verloren.

Moment mal … Was? Einen Teil des Suchindexes verloren? Ist das überhaupt möglich?

Damit für eine Suchanfrage schneller Ergebnissen gefunden werden können, wird die Anfrage im Allgemeinen nur bis zum nächsten der Rechenzentren gesendet, die das entsprechende Produkt unterstützen. Dort wird die Suchmaschinenergebnisseite (Search Engine Results Page, SERP) generiert. Wenn sich an der Zusammensetzung des Indexes etwas ändert, wenn also z. B. Seiten hinzugefügt bzw. entfernt oder Dokumente zusammengeführt werden, müssen die Änderungen auch in all diesen Rechenzentren übernommen werden. Nur so lässt sich sicherstellen, dass allen Nutzern auf der ganzen Welt konsequent Seiten aus der neuesten Version des Indexes verfügbar gemacht werden.

Den Index über all diese Rechenzentren hinweg einheitlich zu halten, ist nicht einfach. Bei großen Diensten, die für unsere Nutzer unmittelbar präsent sind, stellen wir möglicherweise Aktualisierungen dadurch zur Verfügung, dass wir sie erst nur in einem Rechenzentrum umsetzen und sie anschließend Schritt für Schritt auf alle relevanten Rechenzentren ausweiten. Wenn es sich um empfindliche Teile der Infrastruktur handelt, dauert diese Einführung möglicherweise mehrere Tage und wird mit den Instanzen in verschiedenen geografischen Regionen phasenverschoben durchgeführt (Quelle).

Als wir am Freitag, dem 5. April, einige geplante Änderungen am Suchindex vornahmen, gab es Störungen in Teilen des Bereitstellungssystems. Genauer gesagt: Während wir den Index für einige unserer Rechenzentren aktualisierten, wurde eine kleine Anzahl von Dokumenten versehentlich aus dem Index gelöscht. Deshalb „einen Teil des Suchindex verloren“.

Zum Glück haben die Entwickler, die Bereitschaft hatten, das Problem schnell erkannt. Gleichzeitig wurden wir auch durch Meldungen in den sozialen Medien darauf aufmerksam gemacht, dass etwas nicht stimmt. An dieser Stelle auch noch mal danke an alle, die uns damals informiert haben. Dadurch konnten wir schon ein paar Stunden, nachdem das Problem entdeckt wurde, den Suchindex in allen Rechenzentren auf seinen vorherigen stabilen Zustand zurücksetzen – speziell für solche Fälle erstellen wir schließlich Sicherungen.

Am Sonntag, dem 7. April, meldeten wir, dass uns das Problem bekannt sei und sich die Lage schon langsam wieder normalisierte. Da die Rechenzentren allmählich wieder zu einem stabilen Index zurückkehrten, haben wir weiter über Twitter informiert (am 8. April und am 9. April), bis wir sicher waren, dass alle Rechenzentren wieder vollständig auf eine komplette Version des Index zurückgreifen können, was am 11. April der Fall war.

2. Das Problem mit der Search Console

Die Search Console ist eine Auswahl an Tools und Berichten, mit denen jeder Webmaster auf Daten zur Leistung seiner Website in der Google Suche zugreifen kann. Sie zeigt beispielsweise an, wie viele Impressionen und Klicks eine Website täglich in den organischen Suchergebnissen erhält, und liefert Informationen dazu, welche Seiten einer Website in den Suchindex aufgenommen und welche aus ihm ausgeschlossen werden.

Da beim Suchindex die gerade erwähnten Probleme auftraten, wurde die Search Console mit der Zeit ebenfalls inkonsistent. Das liegt daran, dass einige der Daten in der Search Console aus dem Suchindex stammen:

- Damit der Bericht zur Indexabdeckung stimmt, muss der Suchindex in allen Rechenzentren konsistent sein.

- Wenn wir eine Seite im Suchindex speichern, können wir dem Eintrag wichtige Informationen zur Seite hinzufügen, z. B. dass die Seite Markups für Rich-Suchergebnisse enthält. Auf diese Weise kann ein Problem mit dem Suchindex sich auf die Berichte zu Rich-Suchergebnissen in der Search Console auswirken.

Grundsätzlich nutzen viele einzelne Berichte der Search Console Daten aus einer speziellen Datenbank. Diese besteht teilweise aus Informationen, die aus dem Suchindex stammen. Da wir eine frühere Version des Suchindex wiederherstellen mussten, mussten wir auch die Aktualisierung der Datenbank der Search Console unterbrechen. Dies führte bei einigen Berichten dazu, dass die Daten einfroren, und bei anderen wie dem URL-Prüftool zu unzuverlässigen Daten.

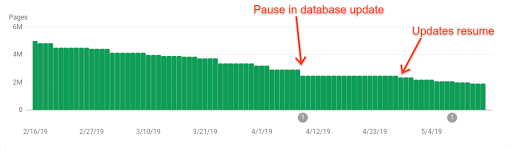

Der Rollback für das gesamte Suchindexproblem dauerte ja wie oben erläutert mehrere Tage und wir konnten uns erst danach darauf konzentrieren, die Datenbank der Search Console zu reparieren. Wir gaben am 15. April bekannt (Tweet), dass es Probleme mit der Search Console gibt und dass wir daran arbeiteten, sie zu beheben. Am 28. April (dem Tag, an dem die Berichte wieder aktuelle Daten erfassten, siehe Grafik oben) schlossen wir die Reparaturarbeiten ab. Am 30. April gaben wir auf Twitter bekannt, dass das Problem gelöst sei (Tweet).

3. Andere Probleme, die nichts mit dem Hauptindexierungsfehler zu tun haben

Die Google-Suche stützt sich auf eine Reihe von Systemen, die zusammenarbeiten. Während einige dieser Systeme eng miteinander verknüpft sind, können an bestimmten Stellen des Systems zur gleichen Zeit Probleme auftreten, die nicht miteinander zusammenhängen.

Als der oben beschriebene Indexierungsfehler auftrat, hatten wir beispielsweise etwa zur gleichen Zeit kurzzeitig Probleme beim Erfassen neuer Inhalte für Google News. Außerdem wurde der Googlebot beim Rendern von Seiten durch bestimmte URLs auf falsche Seiten umgeleitet. Diese Probleme standen in keinem Zusammenhang mit dem Indexierungsfehler und wurden schnell behoben (Tweet 1 und Tweet 2).

Unsere Kommunikation und wie wir sie zukünftig verbessern wollen

Zusätzlich zur Kommunikation auf den sozialen Medien haben wir den Webmastern über zwei weitere Kanäle auch noch mehr Details zur Verfügung gestellt: in der Search Console und in der Search Console-Hilfe.

In der Search Console-Hilfe

Nachdem das Problem vollständig identifiziert wurde, haben wir unsere Hilfeseite zu Datenanomalien in der Search Console aktualisiert. Dort informieren wir über Datenstörungen unseres Search Console-Dienstes, wenn die Auswirkungen eine große Anzahl von Websiteinhabern betreffen.

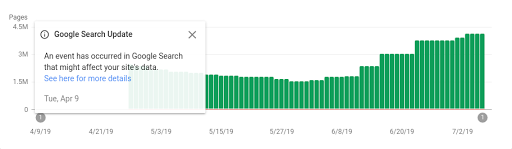

In der Search Console

Da nicht alle unsere Nutzer soziale Medien oder die externe Hilfeseite lesen, haben wir die Search Console-Berichte zusätzlich mit Anmerkungen versehen, um darauf hinzuweisen, dass die Daten möglicherweise nicht ganz fehlerfrei sind (siehe Bild unten). Diese Informationen haben wir nach der Behebung der Fehler hinzugefügt. Wenn man auf "Weitere Informationen" klickt, wird man auf die Seite "Data Anomalies" in der Hilfe weitergeleitet.

Kommunikation in der Zukunft

Bei Problemen erstellen wir abschließend eine sogenannte Post-mortem-Analyse, also ein Dokument, in dem die Ursache eines Fehlers abschließend geklärt wird, und bemühen uns, diesen kein weiteres Mal zu machen. Der gesamte Prozess wird auf Google – Site Reliability Engineering näher beschrieben.

Im Anschluss an die Indexierungsprobleme vom April haben wir in der Post-mortem-Analyse festgehalten, wie wir bei großen Systemausfällen besser mit Webmastern kommunizieren können. Hier unsere wichtigsten Entscheidungen:

- Möglichkeiten untersuchen, wie innerhalb der Search Console selbst Informationen über weit verbreitete Fehler schneller geteilt werden können. Damit haben Webmaster dort eine Hauptanlaufstelle, um Informationen zu erhalten, wenn sie einen Ausfall vermuten.

- Schnellere Veröffentlichung eines Post auf der Seite mit den Datenanomalien der Search Console, falls die Störung relevant, also langfristig in den Daten der Search Console zu sehen ist.

- Weiter so schnell wie möglich über solche Probleme twittern, um Webmaster zu informieren, dass der Fehler bei uns liegt und wir davon wissen.

Diese Schritte sollen ähnliche Situationen in Zukunft für Webmaster insgesamt transparenter machen.

Unsere Vorsätze in die Tat umsetzen: die Fallstudie "Neue URLs nicht indexiert"

Am 22. Mai haben wir unsere neue Kommunikationsstrategie getestet, da ein anderes Problem auftrat. Während der Verarbeitung bestimmter URLs ging unserem Duplikatmanagementsystem nach einem geplanten Infrastruktur-Upgrade der Speicher aus, was dazu führte, dass keine der eingehenden URLs mehr verarbeitet wurde.

Hier eine Zeitachse davon, wie wir die Kommunikation angegangen sind und dabei die drei oben genannten Punkte berücksichtigt haben:

-

Wir haben das Problem bemerkt (gegen 5:30 Uhr kalifornischer Zeit am 22. Mai).

Wir haben dazu getwittert (gegen 6:40 Uhr kalifornischer Zeit am 22. Mai).

Wir haben über die Lösung getwittert (gegen 22 Uhr kalifornischer Zeit am 22. Mai). - Wir haben überlegt, die Seite "Data Anomalies" in der Hilfe zu aktualisieren, haben uns aber dagegen entschieden, da wir keine langfristigen Auswirkungen auf den Großteil der Webmaster-Daten in der Search Console erwartet haben.

- Die Verwirrung, die dieses Problem für viele hervorgerufen hat, hat unsere früheren Schlüsse bestätigt: Wir brauchen eine Möglichkeit, in der Search Console selbst deutlicher zu zeigen, dass es eine Störung in einem unserer Systeme geben könnte, die sich auf Webmaster auswirkt. Eine solche Lösung zu implementieren, wird jedoch wohl etwas dauern. Sobald es Neuigkeiten gibt, werden wir euch informieren.

Letzte Woche gab es übrigens ein weiteres Indexierungsproblem. Wie am 22. Mai haben wir in Tweets darauf hingewiesen, dass ein Problem vorliegt, dass wir an einer Lösung arbeiten und dass das Problem behoben wurde.

So könnt ihr Fehler beheben und uns kontaktieren

Wir hoffen, dass dieser Post klarer macht, wie komplex unsere Systeme sind und dass es manchmal zu Störungen kommen kann. Vielleicht könnt ihr nun auch besser nachvollziehen, wie wir über solche Probleme informieren. Doch obwohl es in diesen Fällen um einen weit verbreiteten Ausfall unserer Systeme ging, sollte man immer dran denken, dass sich die meisten Probleme bei der Indexierung darauf zurückführen lassen, dass die Konfiguration der betreffenden Website eine korrekte Indexierung verhindert. In solchen Fällen können Webmaster die Probleme über die Search Console und unsere Hilfe beheben. Wenn ihr das versucht habt und danach immer noch glaubt, dass ein Problem nicht von eurer Website kommt oder ihr nicht wisst, wie ihr es lösen sollt, sprecht mit uns und unserer Community. Wir sind immer daran interessiert, Feedback von unseren Nutzern zu erhalten. So könnt ihr uns ein Problem melden:

- Besucht unsere Webmaster-Community. Manchmal haben dort bereits andere Webmaster ein Problem gemeldet, das sich auch auf eure Website auswirkt.

- Ihr könnt uns natürlich auch gerne bei Veranstaltungen persönlich ansprechen.

- Über unsere Produkte selbst – auch in der Search Console habt ihr die Möglichkeit, unseren Teams über die Feedbackfunktion wertvolle Hinweise zu geben.

- Oder schreibt uns einfach auf Twitter oder YouTube!